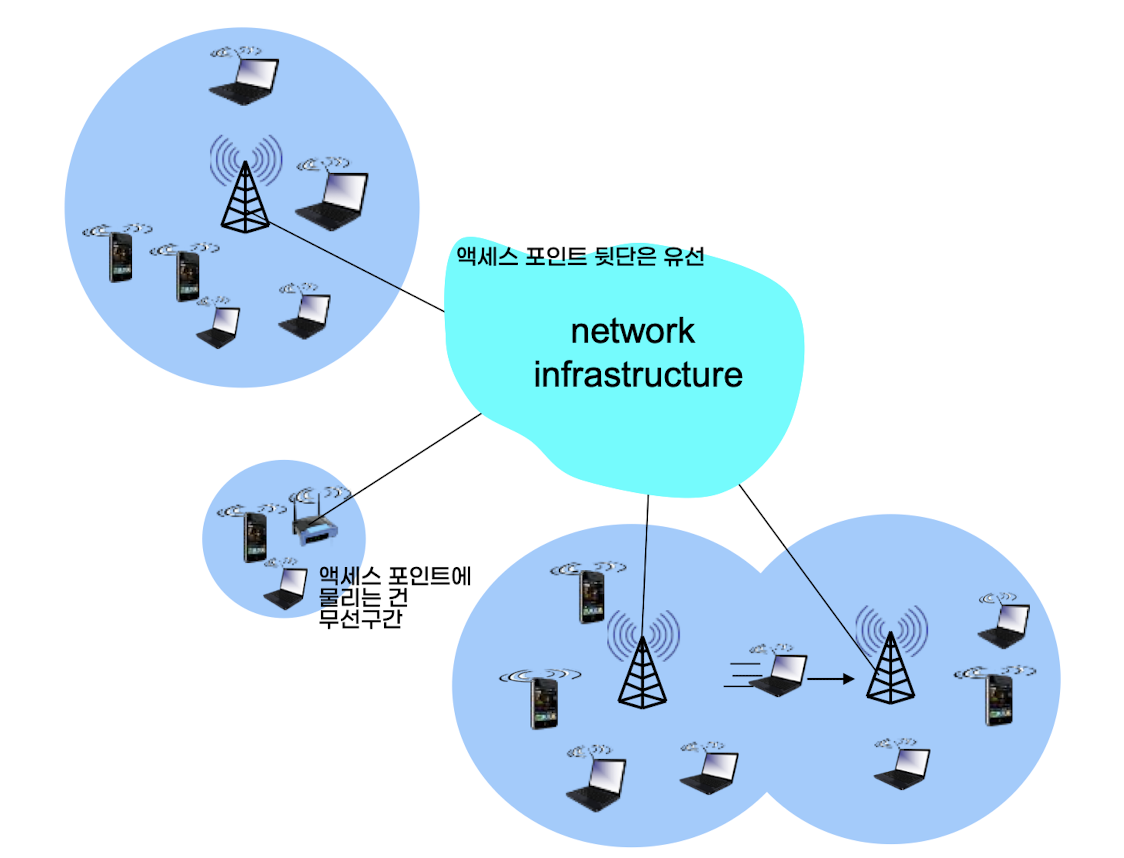

# 컴네 12일차WiFi는 전자기기들이 무선 랜에 연결할 수 있게 해주는 기술로서 IEEE 802.11에 기반한다. 먼저 IEEE 802.11 랜 아키텍처를 살펴보자.무선 호스트들은 기지국(=base station, access point)들과 통신한다. BSS(Basic Service Set)이란 기지국이 데이터를 주고 받을 수 있는 범위를 말한다. cell이라고도 한다.802.11은 해당 범위의 주파수를 대략 11개의 채널로 나눈다. 같은 채널에 여러 AP가 있을 경우 간섭이 발생할 수 있다.호스트는 반드시 AP와 연결되어야 한다. 호스트는 채널을 스캔하여 AP의 이름(SSID)와 MAC 주소를 포함하는 비콘 프레임을 확인한 후 연결할 AP를 선택한다. 연결이 완료되면 DHCP를 통해 IP 주소를 할..